Dans l’industrie, une reconversion ne se joue pas seulement sur des compétences. Elle se joue sur un autre terrain, plus silencieux mais décisif : les peurs, les représentations… et la confiance. C’est exactement là que s’inscrit ce projet de formation immersive en réalité virtuelle, conçu pour un acteur industriel majeur engagé dans une transformation profonde.

Le contexte : un site en reconversion, avec déménagement et évolution des métiers. Parmi les nouveaux postes : le câblage et le brasage (soudure) de cartes électroniques . Un univers qui impressionne. Travail sous binoculaire, gestes fins, posture jugée contraignante… et, très vite, une idée qui s’installe : “ce n’est pas pour moi” — parfois avant même la première heure de formation.

L’enjeu n’était donc pas simplement de “montrer un métier”, mais de déverrouiller l’envie de l’exercer. La VR s’est imposée comme un levier évident : créer une première expérience positive, rassurante et valorisante, pour transformer l’appréhension en curiosité — puis en capacité.

Une immersion qui donne du sens

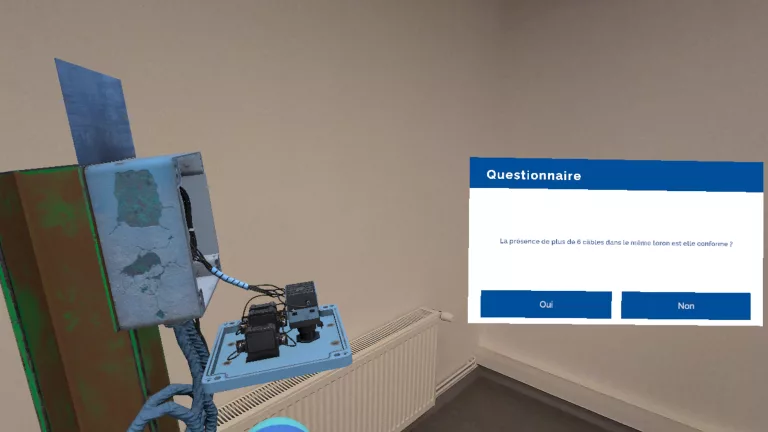

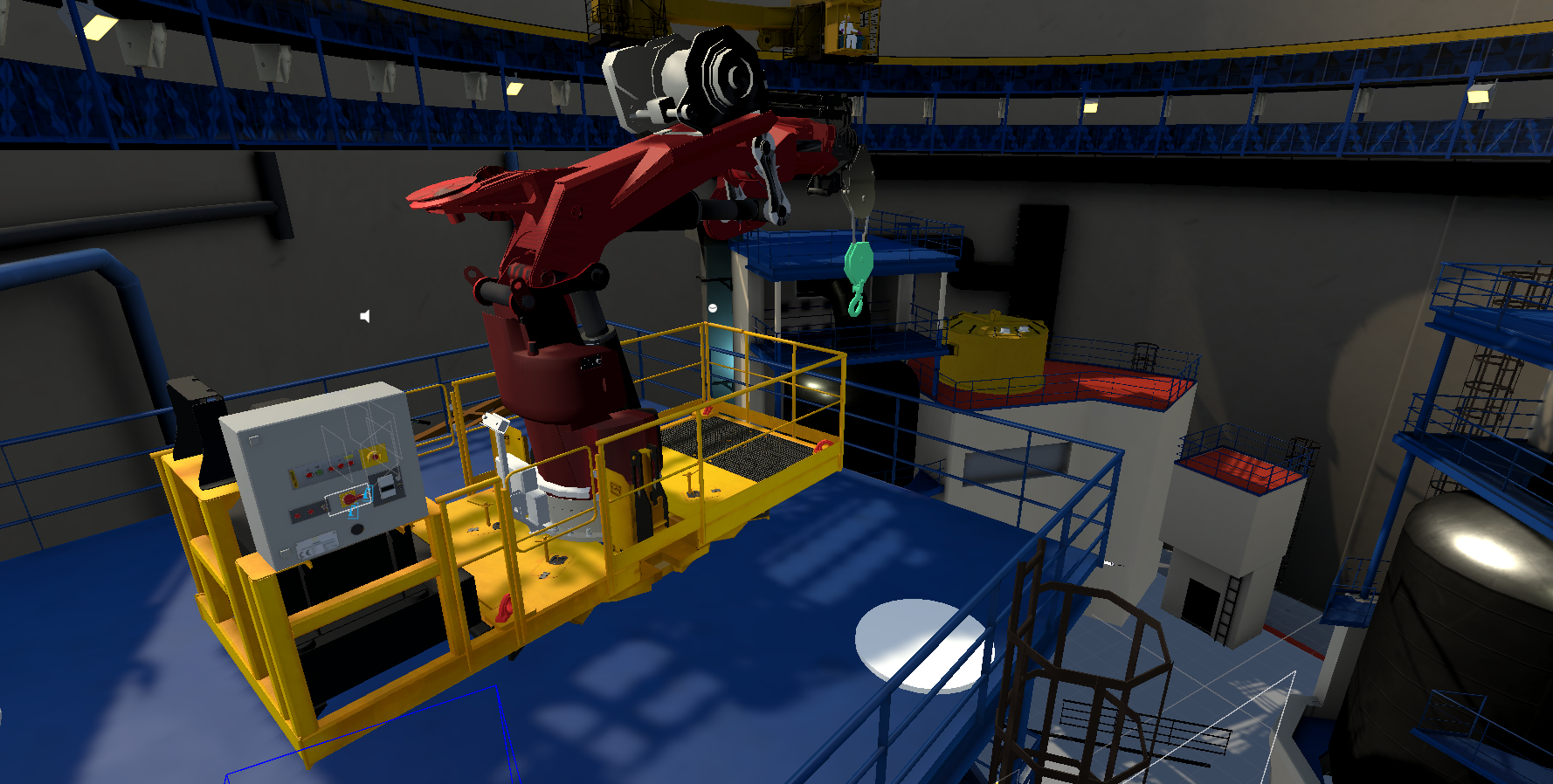

Le dispositif s’appuie sur une narration volontairement forte. L’utilisateur démarre dans un cockpit d’avion : un décor symbole de rigueur, de fiabilité et de précision. Une anomalie est détectée : deux composants manquent sur une carte électronique, le décollage est compromis. L’opérateur est appelé pour intervenir.

Le message est immédiat : le brasage n’est pas un “petit geste technique”. C’est un geste utile, concret, à impact. Puis, transition immersive : l’utilisateur est “téléporté” dans un atelier de brasage reconstitué avec un haut niveau de réalisme, où il réalise lui-même les opérations nécessaires.

Le geste technique démystifié par l’expérience

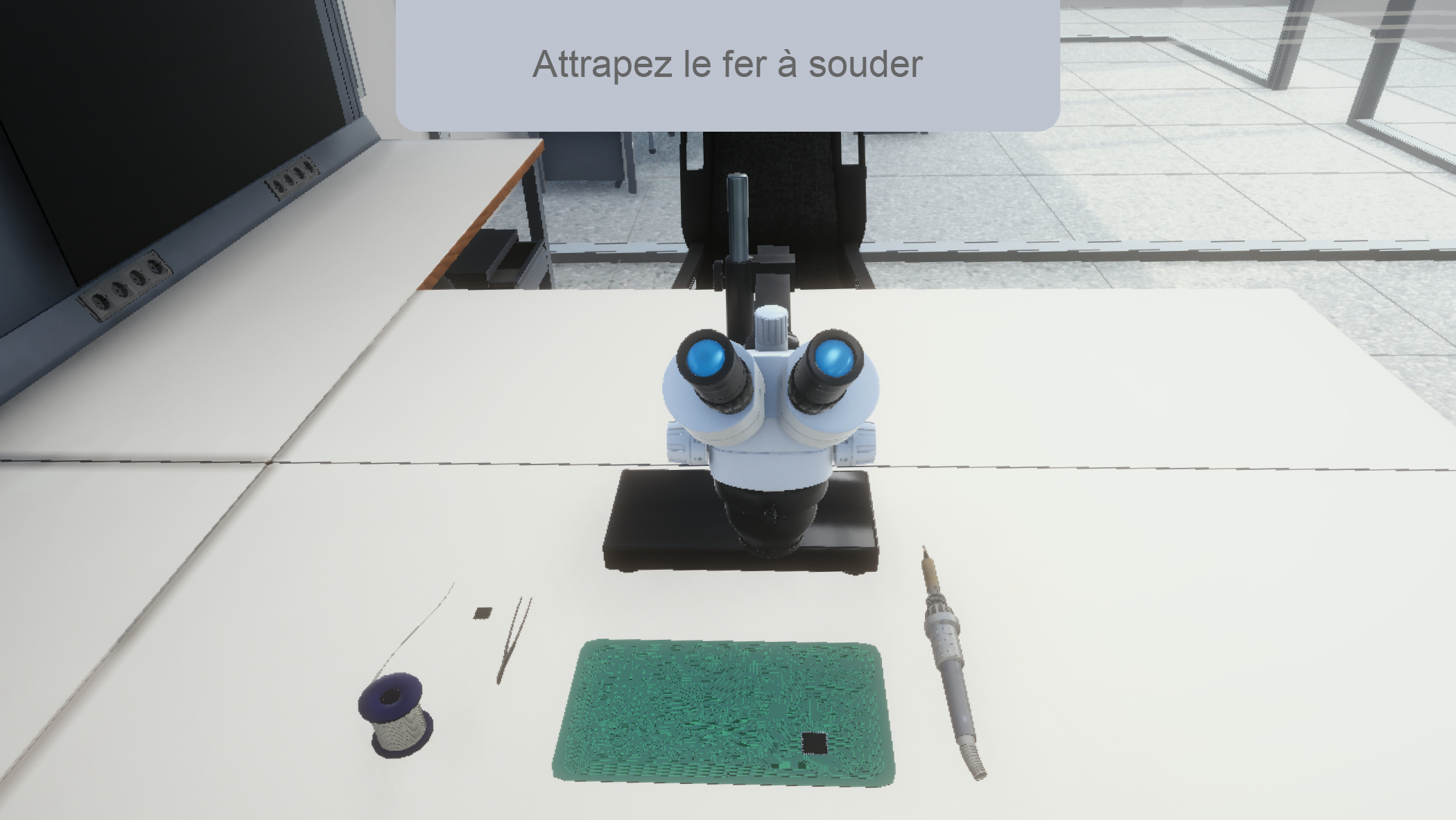

Tout a été pensé pour réduire le stress et éviter la surcharge cognitive. L’utilisateur reste assis, dans une posture proche du réel. Les interactions vont à l’essentiel, avec très peu de commandes. Une voix off, doublée de sous-titres, guide chaque étape avec clarté — sans jamais enfermer l’apprenant dans l’échec.

Les outils (pince, fer à braser, binoculaire) arrivent progressivement. Et surtout, la binoculaire n’est plus un “monstre” : le simple fait d’y regarder déclenche un grossissement automatique, qui rend la précision compréhensible et atteignable. En supprimant l’enjeu de rebut, la pression du résultat et les conséquences immédiates d’une erreur, la réalité virtuelle devient un espace d’apprentissage sécurisant, où l’on ose — et où l’on progresse.

Une cible clairement identifiée : les opérateurs en transition

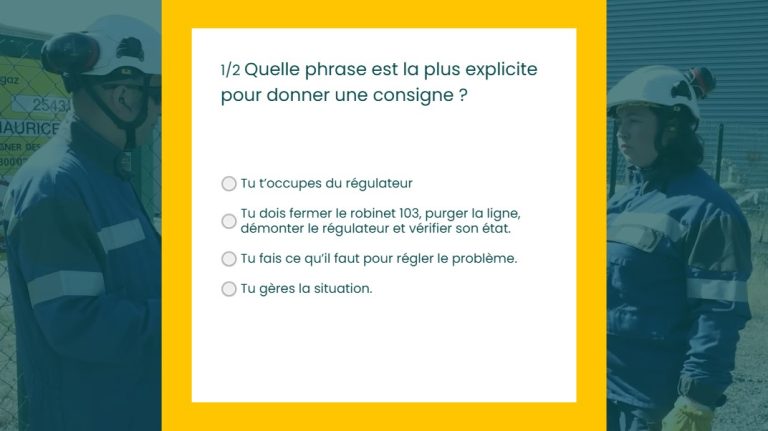

Le dispositif s’adresse à des opérateurs industriels engagés (ou sur le point de l’être) dans une reconversion. Des publics parfois éloignés des formations techniques classiques, pour qui l’image du métier pèse lourd dans l’acceptation du changement.

Côté entreprise, l’outil s’intègre naturellement dans une stratégie RH plus large : il donne aux équipes formation, responsables de sites et directions industrielles un support concret pour accompagner la transformation, sécuriser les parcours et renforcer l’adhésion.

Les outils (pince, fer à braser, binoculaire) arrivent progressivement. Et surtout, la binoculaire n’est plus un “monstre” : le simple fait d’y regarder déclenche un grossissement automatique, qui rend la précision compréhensible et atteignable. En supprimant l’enjeu de rebut, la pression du résultat et les conséquences immédiates d’une erreur, la réalité virtuelle devient un espace d’apprentissage sécurisant, où l’on ose — et où l’on progresse.

La VR, un outil de formation à part entière pour accélérer l’appropriation

Ce projet illustre une VR utilisée avec justesse : pas comme un gadget, mais comme un vrai outil pédagogique. Parce qu’elle permet de vivre le geste, de le comprendre et de le répéter dans un cadre maîtrisé, la réalité virtuelle ne se contente pas de “préparer” : elle forme, au sens plein du terme.

Elle raccourcit le temps de prise en main, lève des freins psychologiques et installe un premier socle de réussite. Et dans une reconversion industrielle, cette première réussite change tout : elle transforme une tâche perçue comme inaccessible en compétence en cours d’acquisition — et redonne aux opérateurs ce qui fait tenir dans la durée : la confiance dans le geste.

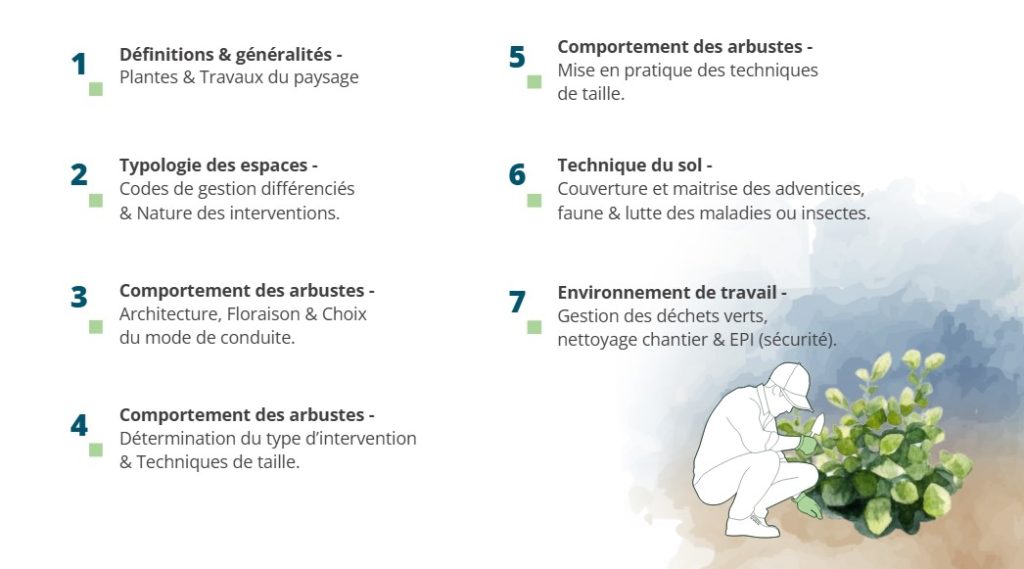

renforcer la maîtrise des règles professionnelles P.E.2 – Travaux d’entretien des arbustes,

renforcer la maîtrise des règles professionnelles P.E.2 – Travaux d’entretien des arbustes,